Multilink Treinamentos

Já são milhares de alunos embarcados. Embarque você também!

- 00H

- 00Min

- 00Seg

Sobre

A Multilink Treinamentos é uma empresa especializada em cursos e treinamentos Marítimos e Petrolíferos Offshore. Desde os anos 2000, a Multilink ajuda aspirantes da área offshore a ingressarem no mercado de trabalho de plataformas e profissionais a manterem-se atualizados com suas certificações obrigatórias.

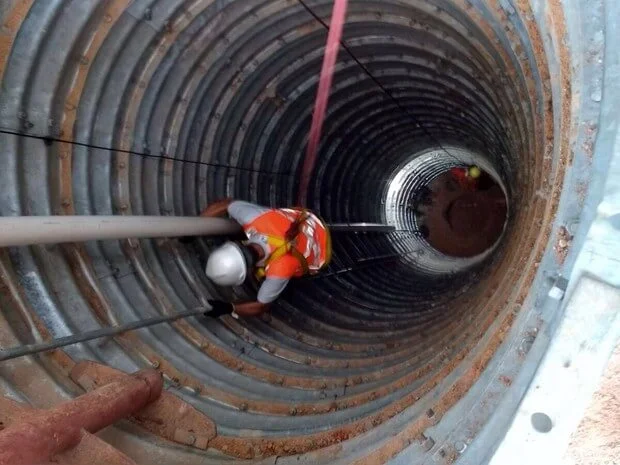

Qualifique-se para trabalhar na área offshore. Conheça nossos cursos e treinamentos offshore: Salvatagem CBSP, HUET, Nr35, Nr33 e Homem de Área.

Salvatagem CBSP

Curso básico de segurança de plataforma para quem deseja trabalhar embarcado.

HUET

Treinamento de Escape de Aeronave Submersa. Muito requisitado pelas empresas!

Homem de área

Treinamento para Auxiliar de Movimentação de Carga, Sinaleiro & Rigge.

Cursos semipresenciais

Maior praticidade e comodidade para você realizar seus cursos offshore e se qualificar para trabalhar embarcado

Faça parte você també

Muito mais benefícios para você!

Aulas em Grupo

Junte seu grupo de 5 amigos e receba diversos benefícios! Quanto maior o grupo melhores os benefícios.